Diskussionen om syntetiskt urval (Synthetic Samples) är en av de hetaste, men också mest missförstådda, inom marknadsanalys just nu. Frågan är om generativ AI kan ersätta mänskliga paneldeltagare, eller om dess roll stannar vid att förstärka och fylla luckor i existerande data.

För att navigera rätt måste vi först skilja på begreppen. Enligt branschexperten Ray Poynter (ESOMAR) bör vi skilja på:

- Syntetisk data: Information som genererats för att efterlikna statistiska egenskaper hos verklig data (ett statiskt dataset).

- Personas (eller Digital Twins): AI-agenter skapade för att simulera beteenden och åsikter hos specifika målgrupper eller individer.

Löftet: Snabbhet och effektivitet

Hypotetiskt erbjuder syntetiska urval stora fördelar: kortare intervjutider för människor (genom att låta AI fylla i luckor, s.k. Augmented Data) och möjligheten att snabbt testa hypoteser innan man går ut i fält. Men är kvaliteten tillräckligt hög?

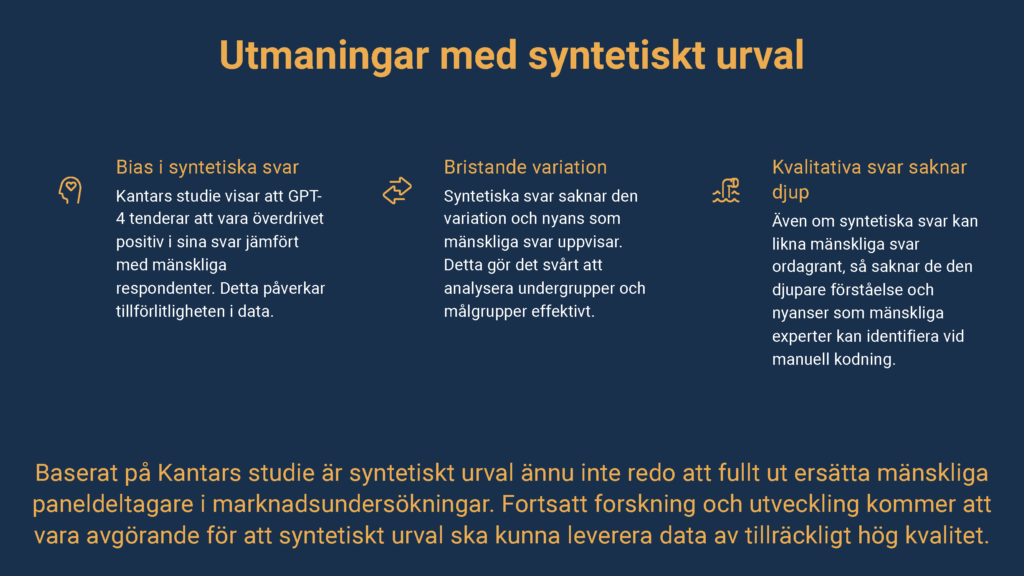

Utmaningarna: Vad säger datan?

En jämförelse mellan teori (Poynter) och praktik (en studie av Kantar där GPT-4 ställdes mot mänskliga respondenter) pekar på tre tydliga risker som måste hanteras:

- ”Trimming of Extremes” och bristen på nyansRay Poynter varnar för att syntetisk data tenderar att ”kapa ytterligheterna”. AI-modeller söker sig mot mitten, vilket innebär att standardavvikelsen minskar. Kantars studie bekräftar detta i praktiken: när de upprepade experiment 50 gånger blev GPT-4 svar stereotypa och saknade den naturliga variation som finns hos människor. AI levererade ”genomsnittliga” svar snarare än den spretighet som ofta rymmer de verkliga insikterna.

- Logik vs. Emotion (Positivity Bias)AI är bra på logik men sämre på känslor. Kantar fann att GPT-4 svar låg nära människors när det gällde rationella frågor (t.ex. prisets betydelse), men avvek kraftigt vid frågor som krävde emotionell eftertanke. Dessutom uppvisade AI en överdriven ”Positivity Bias” – den var betydligt mer positiv till produkter än vad verkliga konsumenter var. Poynter beskriver detta som ”Reduced Emotional Depth”; AI är mer logisk och mindre empatisk än en människa.

- Risken för ”Synthetic Data Collapse”Om vi ersätter för mycket mänsklig data med syntetisk, riskerar vi att hamna i en loop där framtida AI-modeller tränas på data skapad av gamla AI-modeller. Poynter kallar detta Synthetic Data Collapse. Utan ett kontinuerligt inflöde av färsk, mänsklig ”Ground Truth”-data kommer modellerna till slut att divergera från verkligt mänskligt beteende och bli oanvändbara.

Slutsats: Komplement, inte ersättare

Sammanfattningsvis visar både ESOMARs ramverk och Kantars tester att syntetiskt urval idag inte är redo att ersätta mänskliga respondenter, särskilt inte för djupare insikter, segmentering eller känslomässiga drivkrafter.

Däremot finns stor potential i Augmented Data – att använda AI för att förstärka dataset, fylla i saknade värden eller agera bollplank i tidiga skeden. Men för beslutsfattande krävs fortfarande data av hög kvalitet, och i dagsläget är den datan mänsklig.

Uppdaterad våren 2026

Lyssna på avsnittet genom en AI-genererad podcast: